“Sve što moramo imati je samo ljudski oblik da bismo bili žrtva.” Tako advokat Carrie Goldberg opisuje rizik od deepfake pornografije u doba vještačke inteligencije.

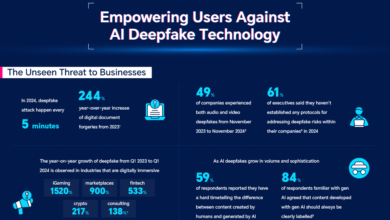

Osvetnička pornografija – ili nedopušteno dijeljenje neprimjerenih slika – postoji skoro koliko i internet, proliferacija AI alata znači da svako može biti meta ovog oblika uznemiravanja, čak i ako nikada nije snimio ili poslao golu fotografiju. Alati umjetne inteligencije sada mogu dodati lice osobe na golo tijelo ili manipulirati postojećim fotografijama kako bi izgledalo kao da osoba ne nosi odjeću.

U protekloj godini, mete pornografskih slika generisanih vještačkom inteligencijom kretale su se od istaknutih žena kao što su Taylor Swift do srednjoškolki čije su fotografije zloupotrebljene.

Za nekoga ko otkrije da je postao predmet deepfake pornografije, iskustvo je obično zastrašujuće, rekao je Goldberg, koji vodi njujoršku firmu CA Goldberg Law koja zastupa žrtve seksualnih zločina i uznemiravanja na internetu. “Pogotovo ako su mladi i ne znaju kako da se izbore, a internet je ogromno, maglovito mjesto”, rekao je.

Ali postoje koraci koje mete ovog oblika uznemiravanja mogu poduzeti kako bi se zaštitile i mjesta na koje se mogu obratiti za pomoć, rekao je Goldberg u intervjuu na CNN-ovom novom tehnološkom podcastu.

Uslovi korištenja imaju za cilj da demistifikuju nove tehnologije sa kojima se ljudi susreću u svom svakodnevnom životu. (Cijeli razgovor sa Goldbergom možete poslušati ovdje .)

Goldberg je rekao da bi za ljude koji su žrtve slika generisanih umjetnom inteligencijom, prvi korak – koliko god bio kontraintuitivan – trebao biti njihovo dokumenotvanje.

“Potrebno je da se to skine s interneta što je prije moguće”, rekao je Goldberg. „Ali ako želite da imate mogućnost da to krivično prijavite, potrebni su vam dokazi.”

Zatim mogu potražiti obrasce koje platforme kao što su Google , Meta i Snapchat pružaju da traže uklanjanje eksplicitnih slika. Neprofitne organizacije poput StopNCII.org i Take It Down također mogu pomoći u uklanjanju takvih slika na više platformi odjednom.

Borba za ukidanje lažnih eksplicitnih slika i deepfakes dobila je rijetku dvostranačku podršku. Grupa tinejdžera i roditelja koji su bili pogođeni pornografijom generiranom umjetnom inteligencijom svjedočila je na saslušanju na Capitol Hillu, gdje je republikanski senator Ted Cruz predstavio nacrt zakona — podržan od strane demokratske senatorke Amy Klobuchar i drugih — koji bi činio zločinom objaviti takve slike i zahtijevao od platformi društvenih medija da ih uklone nakon obavještenja žrtava.

Za sada, žrtvama je ostavljeno da se snalaze. U Bosni i Hercegovini ne postoje krivični zakoni koji sprječavaju stvaranje ili dijeljenje eksplicitnih deepfake simaka odraslih. (Seksualne slike djece koje generiše AI obično potpadaju pod materijalne zakone o seksualnom zlostavljanju djece.)

Žrtve ne mogu mnogo učiniti da to spriječe… Nikada ne možemo biti potpuno bezbjedni u digitalnom društvu, ali moram se dodatno potruditi kako ne bi bili lake mete” kazao je Goldberg.